概要 #

公開型推論APIサービス では Node-AI で作成したAIモデルを用いた推論をAPIとして手軽に利用できます。

リアルタイム推論のような高レスポンスな動作を必要としないユースケースにおすすめです。その他動作条件に制約がある場合は

オンプレミス型の推論API の利用をご検討ください。

推論値を得るまでの流れ #

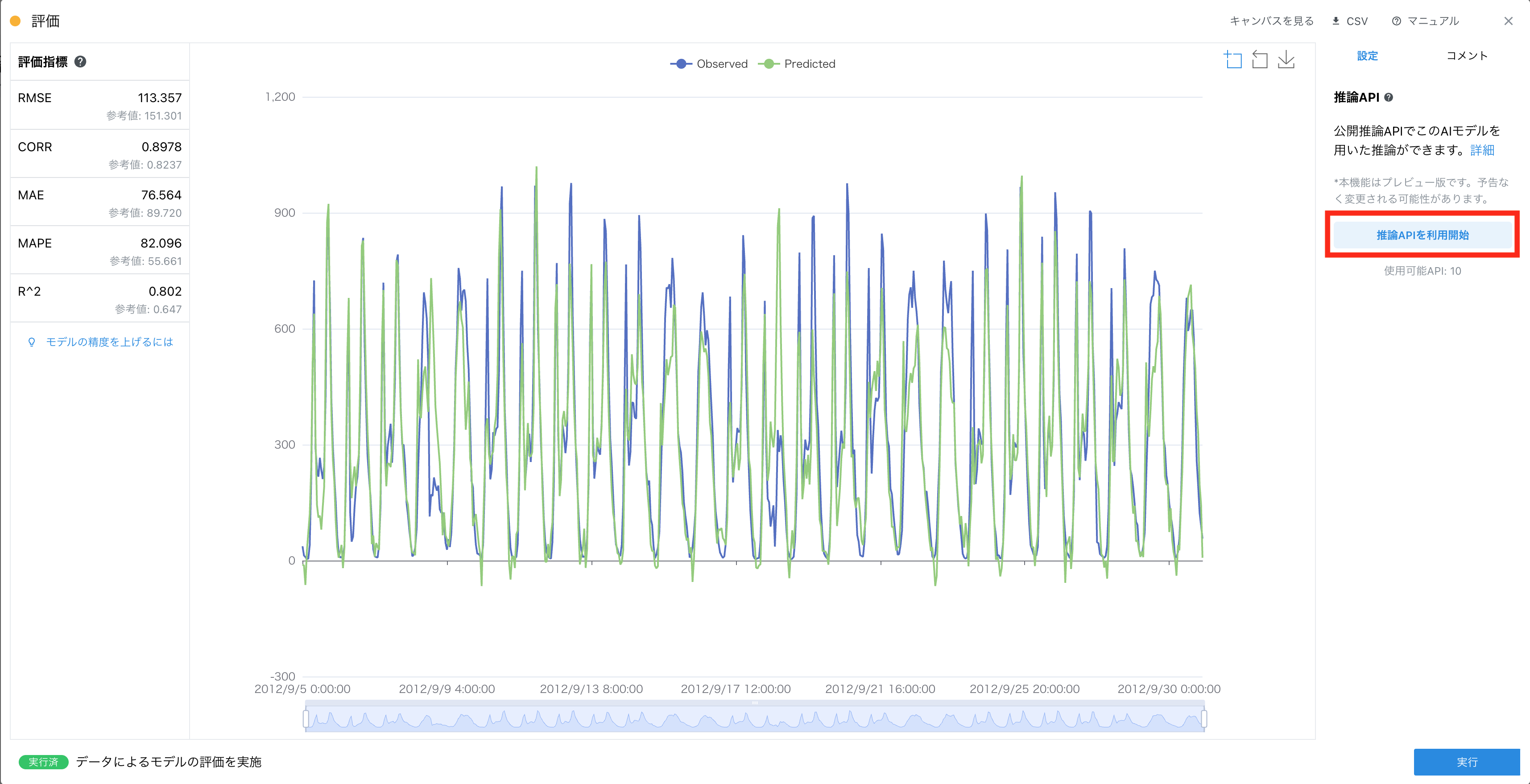

- 評価カード または 異常度可視化カード から対象のAIモデルについて「推論APIを利用開始」ボタンを押します

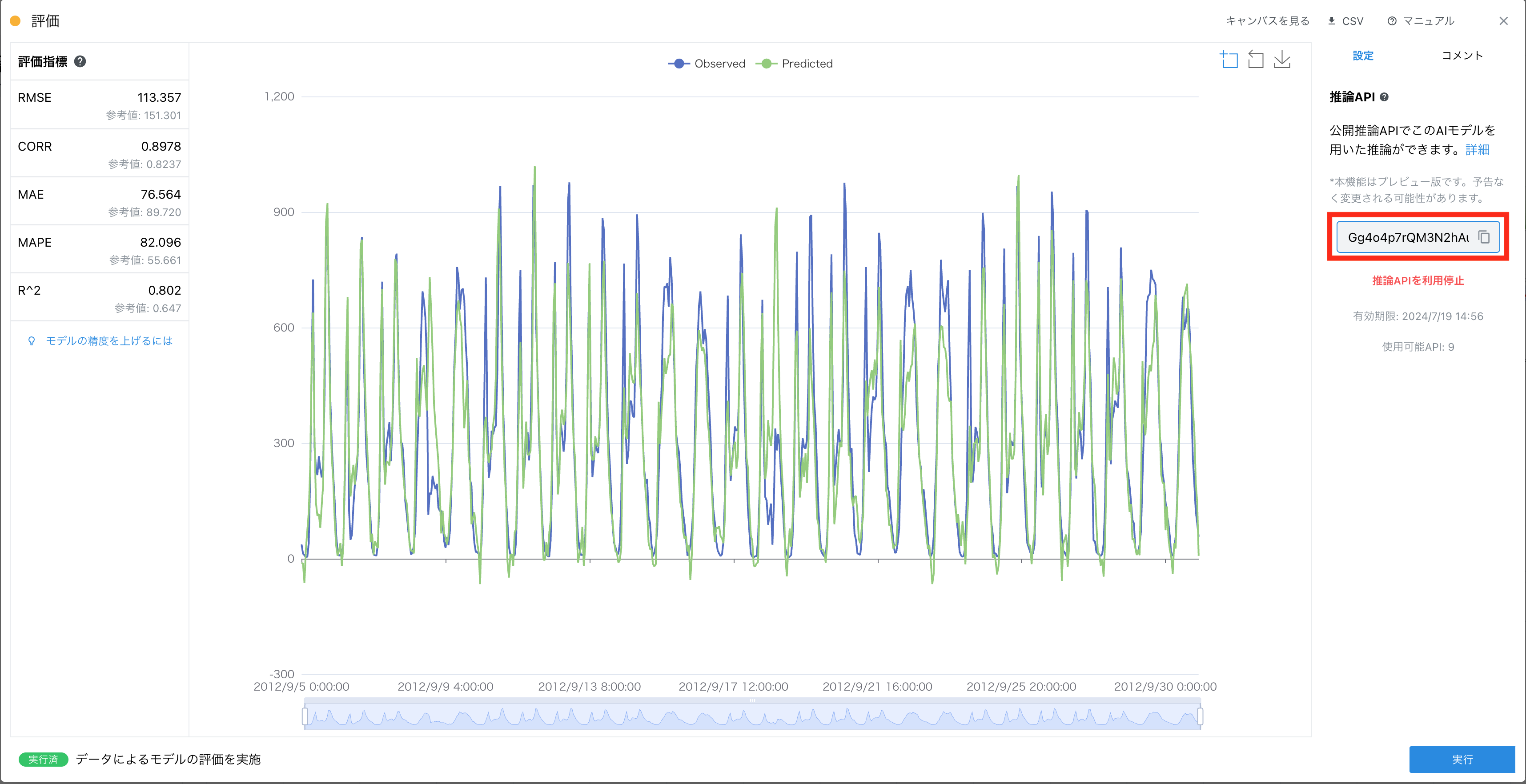

- モデルトークンが発行されるので所定の形式(後述)でAPIを利用すると推論値を取得できます

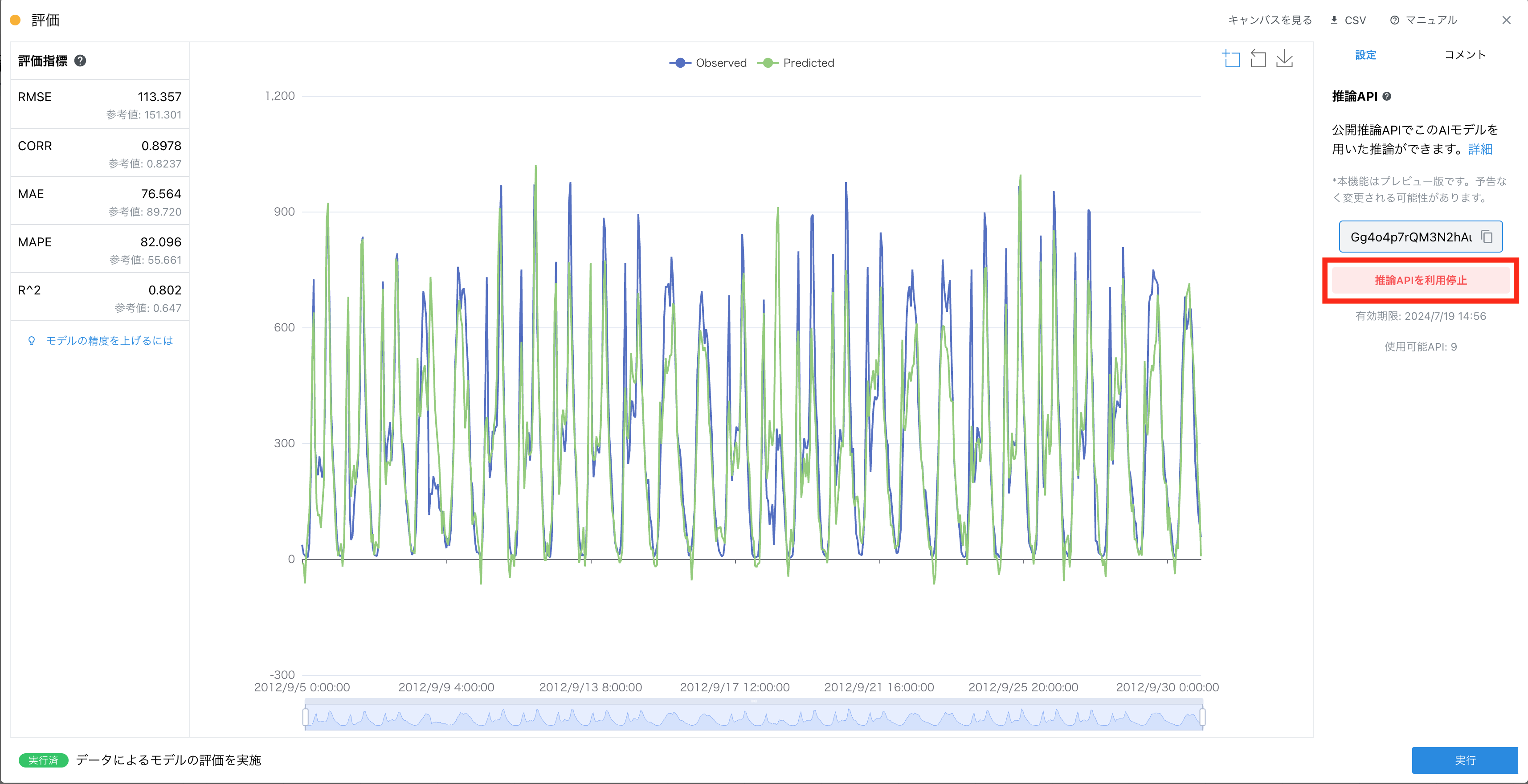

- 利用を終了したい場合は、利用開始をしたカードの詳細画面から推論APIを利用を停止できます

制限事項 #

- トレーニングチーム、またはFreeプランのチームでは1チームにつき同時で最大10のAIモデルを推論APIでご利用になれます

- トレーニングチーム、またはFreeプランのチームではモデルトークンは60分後に自動で無効化されます

- Businessプランでは1チームにつき同時に最大100のAIモデルを推論API利用でご利用になれます

- 推論に利用するデータサイズは5MB以下である必要があります

- 実行に5分以上かかる処理はエラーとなります

- 高頻度でAPIを利用された場合には一定時間アクセス制限がかかる場合があります

- 各モデルトークンにおいて1分間に20リクエストまでご利用いただけます

- 各IPアドレスにおいて1分間に60リクエストまでご利用いただけます

- 現在 Prophetモデル および Informerモデルを用いた推論には対応していません

推論API利用のためにモデルトークンを取得する #

評価カード または異常度可視化カード の設定パネル内の「推論APIを利用開始」ボタンを押します。

ランダムな文字列であるモデルトークンが発行されるので、これをコピーします。

推論APIを利用して推論を実行する #

curlコマンド、Pythonでの利用方法を記載します。

curlコマンドから利用する場合 #

コマンド内の /path/to/file.csv に推論に用いるCSVファイルのパスを指定してください。Windows PowerShellから利用する場合にはコマンド中のcurlをcurl.exeに置き換えて実行してください。

なお、Windowsでcurlがデフォルトで使えるのはWindows10 Version 1803以降です。

コマンド

curl -H "model-token: モデルトークン" -F "file=@/path/to/file.csv" -X POST https://api.inference.nodeai.io/v1/inference

実行結果例

index,Predicted

2011-01-15 06:00:00,97.5111312866211

実行結果をoutput.csvとして保存したい場合

curl -H "model-token: モデルトークン" -F "file=@/path/to/file.csv" -X POST https://api.inference.nodeai.io/v1/inference -o output.csv

Pythonから利用する場合 #

推論値を文字列として取得する例

import requests

MODEL_TOKEN = "ここにモデルトークンを入力"

CSV_FILEPATH = "ここに推論に用いるcsvファイルのパスを入力"

response = requests.post(

"https://api.inference.nodeai.io/v1/inference",

headers={"model-token": MODEL_TOKEN}

files={"file": open(CSV_FILEPATH, "rb")},

)

predicted = response.content.decode("utf-8")

print(predicted)

推論API利用を停止する #

下記のいずれかの操作により無効化できます。

評価カードまたは異常度可視化カードの設定パネル内のボタンから停止する (下図参照)- チームを削除する

- キャンバスを削除する

- 該当する 実験管理レコードを削除する

- (Businessプラン契約中の場合は) Businessプランを解約する

API一覧 #

利用可能な推論実行以外の主要なAPIを記載します。

Swagger形式の詳細なドキュメントは

こちらから確認することができます。

ご利用の際は全て先頭にhttps://api.inference.nodeai.io/をつけてください。

(利用例: curl -H "model-token: モデルトークン" -X GET https://api.inference.nodeai.io/v1/exists)

| API | Method | 内容 | レスポンス例 |

|---|---|---|---|

v1/exists |

GET | モデルが存在するかどうかを取得 | {"exists":true} |

v1/length |

GET | 推論の際に必要な最低データ数を取得 | {"length":168} |