4.1.e. Informer モデルの設計 #

機能制限について

Informerは環境によってはご利用いただけません。

4.1.e.1. 機能概要 #

Informer は Transformer ベースの長期時系列予測モデルです。

Transformer は長期間にわたる依存関係を考慮した予測が可能ですが、計算コストが高いことが問題です。 Informer はこの欠点を改良し、より高速にメモリ使用量を削減して学習が可能です。

詳しい式はNTTコムの 時系列データ分析ノウハウ集「ごちきか」該当記事を参照ください。

利用する際の注意事項

- 本機能はアドバンスドな機能です。利用の際には、データセットの特性や分析の目的に応じてパラメータを設定してください。

- Informerによる学習は大変時間がかかる場合があります。学習が終わらない場合は学習に利用するデータ量を小さくするなどの対応を検討してください。

- Informerを用いた場合は、要因分析、バリデーションなど一部機能に制限がある場合があります。

4.1.e.2. 入力と出力 #

なし

| 種別 | 接続先 |

|---|---|

| 設計済みモデル | 学習 |

4.1.e.3. 操作方法 #

4.1.e.3.1. 結線 #

設計した AI モデル( Informer)と、学習用のデータ(時間窓切り出し 実施前 のものに限る) を結線してください。

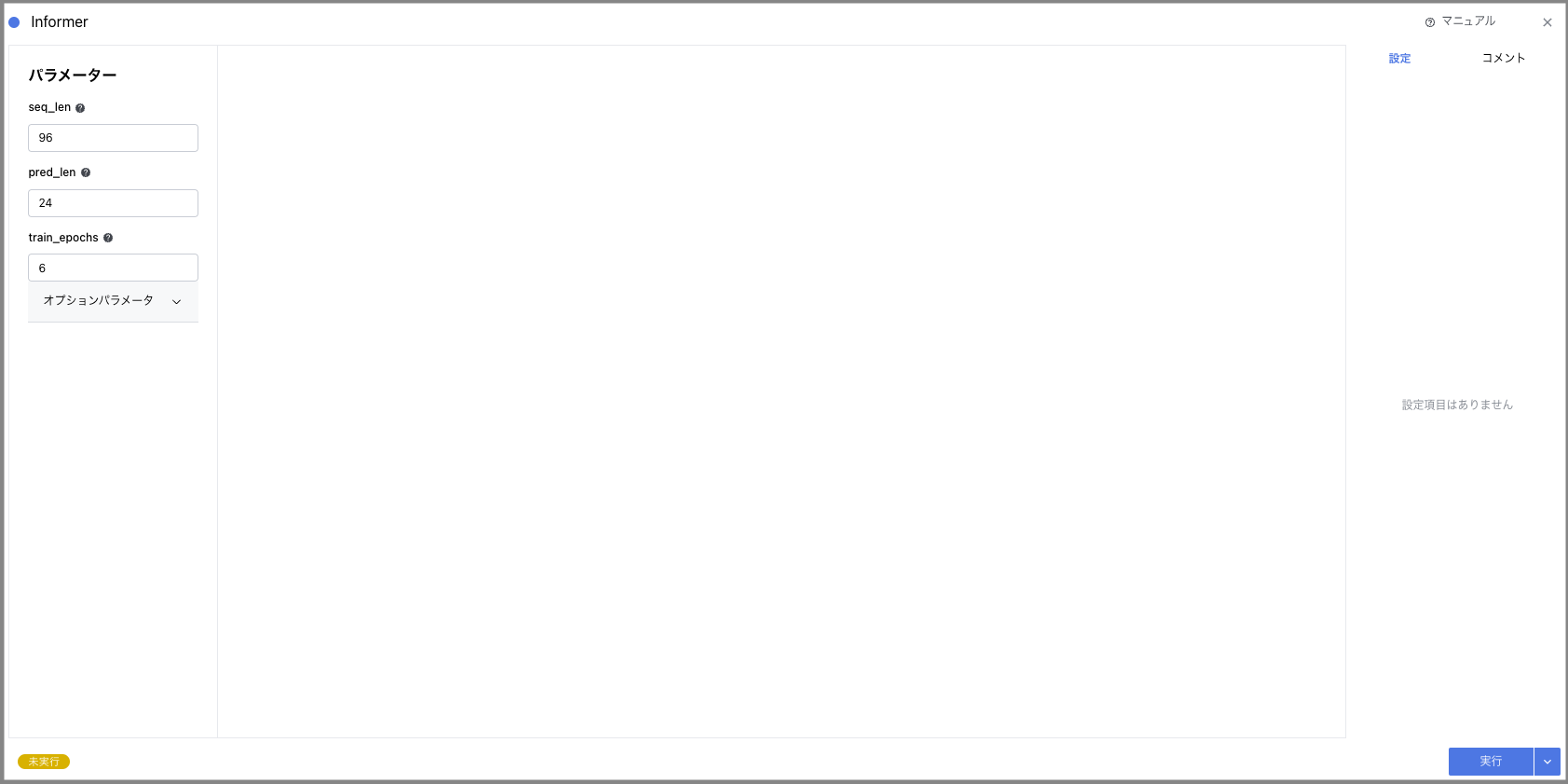

4.1.e.3.2. 各種パラメータの設定 #

設定可能なパラメータは以下の通りです。各パラメータの設定は、モデルの性能と過学習のリスクに直接影響を与えるため、データセットの特性や解析の目的に応じて設定してください。

| パラメータ | 設定範囲 | 必須パラメータ | 備考 |

|---|---|---|---|

seq_len |

1以上の整数値 | ○ | Informer encoder の入力シーケンス長。 |

pred_len |

1以上の整数値 | ○ | 予測シーケンスの長さ。モデルが未来を予測するためのタイムステップ数。 |

train_epochs |

1以上の整数値 | ○ | 学習エポック数。モデルがトレーニングデータを何回繰り返して学習するか。 |

d_model |

1以上の整数値(空の場合は256が自動で採用) | モデルの次元。モデル内の各層の出力サイズ。 | |

n_heads |

1以上の整数値(空の場合は8が自動で採用) | Attention の head 数。 | |

e_layers |

1以上の整数値(空の場合は2が自動で採用) | encoder 層数。より多い層は、より複雑な関係性をモデル化できるが、計算資源と過学習のリスクが増える。 | |

d_layers |

1以上の整数値(空の場合は2が自動で採用) | decoder 層数。デコーダーの深さ。 | |

d_ff |

1以上の整数値(空の場合は2048が自動で採用) | 出力全結合層の次元。 | |

embed |

文字列 | 時間特徴 encoding (defaults to timeF). timeF, fixed, learned. 時間特徴量の埋め込み方法。 | |

dropout |

0以上1以下の浮動小数点(空の場合は0.0が自動で採用) | ドロップアウト率。過学習を防ぐために特定のノードを無効にする割合。 | |

batch_size |

1以上の整数値(空の場合は32が自動で採用) | 学習入力データのバッチサイズ。 | |

learning_rate |

0以上1以下の浮動小数点(空の場合は0.0001が自動で採用) | 学習率。モデルのパラメータ更新のステップサイズ。 | |

label_len |

1以上の整数値(空の場合はseq_lenの値が自動で採用) | Informer decoder のトークン開始長。 |

4.1.e.3.3. 設計の保存 #

- “実行” ボタンを押して、設定を保存します。

- 設定内容に矛盾が存在する場合は、エラーが表示されます。

- 処理時間が 5 分を超えるとタイムアウトし、処理が強制終了されます。