4.1.d. LightGBM モデルの設計 #

4.1.d.1. 機能概要 #

LightGBM は Microsoft によって開発された高速な決定木学習アルゴリズムです。

勾配ブースティングに基づき、複数の決定木を組み合わせて高い精度のモデルを構築することが可能です。 欠損値をそのまま扱え、異常値の影響を受けにくい、といった特徴があります。

ランダムフォレストや線形回帰と比較して、大規模データセットや複雑な特徴を持つデータに対して効率的に学習を行うことができます。

詳細は 公式ドキュメントを参照してください。

4.1.d.2. 入力と出力 #

なし

| 種別 | 接続先 |

|---|---|

| 設計済みモデル | 学習 |

4.1.d.3. 操作方法 #

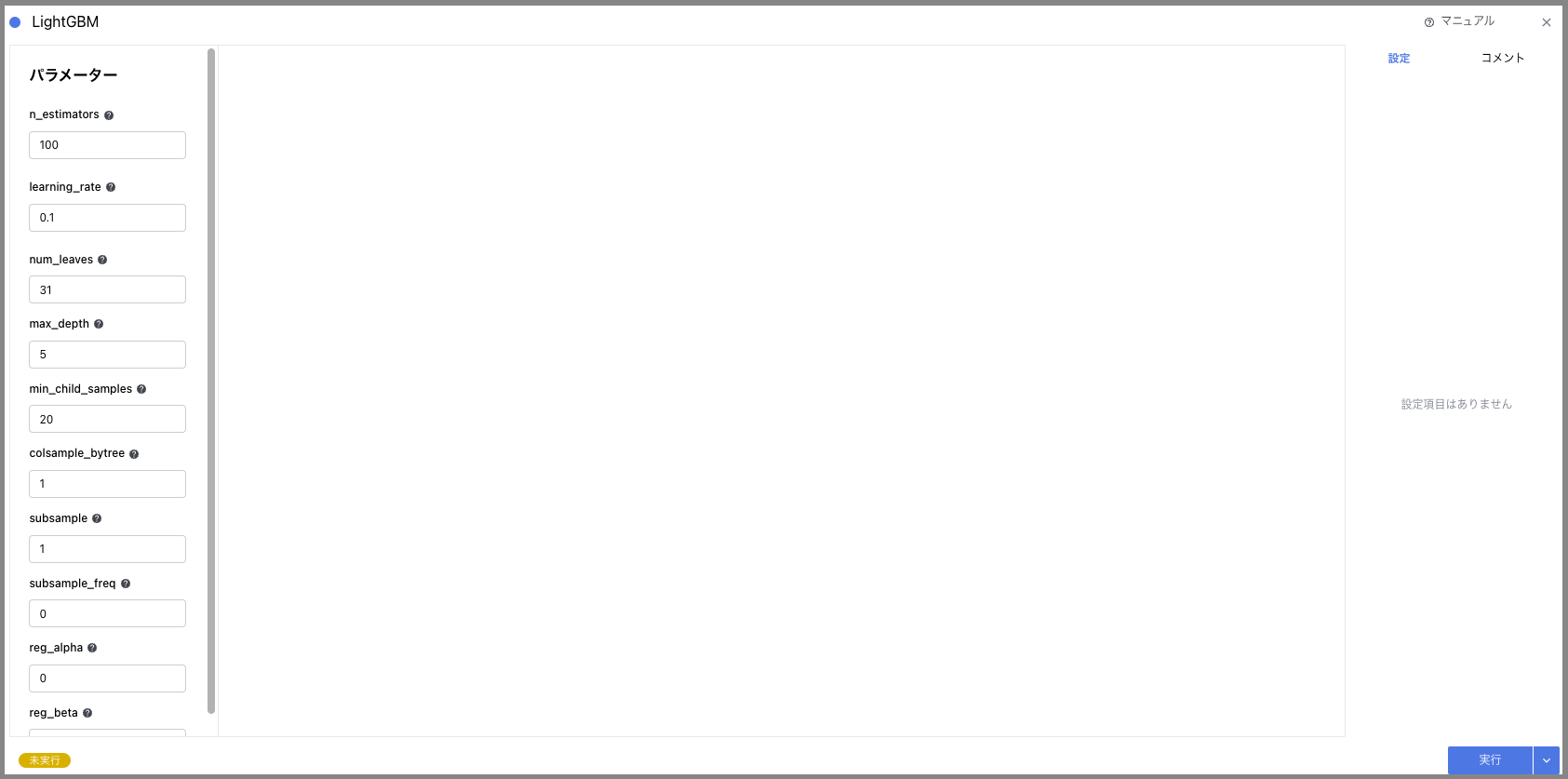

4.1.d.3.1. 各種パラメータの設定 #

設定可能なパラメータは以下の通りです。各パラメータの設定は、モデルの性能と過学習のリスクに直接影響を与えるため、データセットの特性や解析の目的に応じて設定してください。

| パラメータ | 設定範囲 | 必須パラメータ | 備考 |

|---|---|---|---|

| n_estimators | x ≥ 1 (int) | 〇 | 学習する決定木の数を指定します。モデルの複雑度に影響があります。適切な値を設定しないと過学習のリスクがあります。 |

| learning_rate | x > 0 (float) | 〇 | 学習率を指定します。大きい値ほど学習が進みやすくなりますが、学習の安定性が低下する可能性があります。 |

| num_leaves | 2 ≤ x < 2^max_depth (int) | 〇 | 木の最大葉数を指定します。大きいほど過学習に直結するため注意が必要です。また大きい値ほどメモリ消費が増加します。 |

| max_depth | 2 ≤ x ≤ 9 (int) | 〇 | 木の深さを指定します。はモデルの複雑度に影響があります。適切な値を設定しないと過学習のリスクがあります。 |

| min_child_samples | x ≥ 1 (int) | 1 枚の葉に含まれる最小のデータ数を指定します。 | |

| colsample_bytree | 0 < x ≤ 1 (float) | 木の作成に使用する特徴量の割合を指定します。多数の特徴量がある場合、この値を低く設定することが一般的です。 | |

| subsample | 0 < x ≤ 1 (float) | ツリーごとのサンプル割合を指定します。小さくすると過学習の防止に有効です。一方で、低すぎると学習不足の可能性があります。 | |

| subsample_freq | x ≥ 0 (int) | バギングの頻度を指定します。0 はバギングは実行しません。 | |

| reg_alpha | x ≥ 0 (float) | L1 正則化に相当します。大きな値は重要な変数以外を無視する様なモデルになる可能性があります。0.1 程度が適切です | |

| reg_beta | x ≥ 0 (float) | L2 正則化に相当します。特徴量が多い場合などに大きい値を設定することが多いです。0.1 程度が適切です。 |

4.1.d.3.2. 設計の保存 #

- “実行” ボタンを押して、設定を保存します。

- 設定内容に矛盾が存在する場合は、エラーが表示されます。

- 処理時間が 5 分を超えるとタイムアウトし、処理が強制終了されます。